Face au défi de la transformation digitale, le recours à l’assurance algorithmique est une opportunité à saisir.

Face au défi de la transformation digitale, le recours à l’assurance algorithmique est une opportunité à saisir.

Portée par l’émergence des objets connectés et l’énorme source de données qu’ils génèrent, l’assurance algorithmique promet d’anticiper et de réduire le risque, d’ajuster la tarification des contrats et de proposer des solutions assurantielles de plus en plus personnalisées.

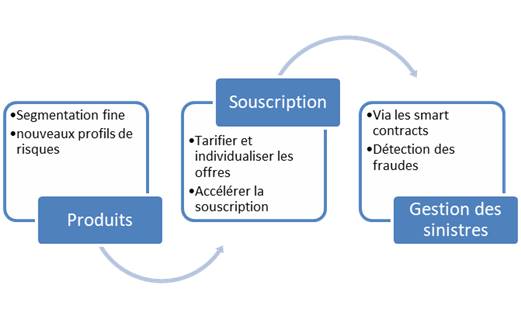

Tous les maillons de la chaîne de valeur de l’assurance sont concernés :

- en amont, le big data permet de mieux appréhender les risques grâce aux objets connectés et de pouvoir adopter l’offre et les tarifs en tenant compte du comportement de l’assuré ;

- en aval, des outils stratégiques ont été conçus afin de combattre la fraude et de prévoir des indemnisations plus efficaces.

Le secteur de l’assurance est particulièrement concerné par la protection des données personnelles. La collecte et le traitement d’informations concernant les assurés sont indispensables au fonctionnement de l’assurance algorithmique et plus largement à l’exercice du métier.

Les professionnels de l’assurance doivent ainsi s’adapter au nouveau cadre législatif instauré par l’entrée en application du RGPD le 25 mai 2018 (1).

Profilage et algorithmes décisionnels

La nouvelle définition du profilage

Le premier domaine dans lequel le RGPD aura sans aucun doute un impact majeur sur le secteur des assurances est celui du profilage.

Le règlement introduit une définition large du « profilage » défini comme :

Toute forme de traitement automatisé de données à caractère personnel consistant à utiliser ces données à caractère personnel pour évaluer certains aspects personnels relatifs à une personne physique, notamment pour analyser ou prédire des éléments concernant le rendement au travail, la situation économique, la santé, les préférences personnelles, les intérêts, la fiabilité, le comportement, la localisation ou les déplacements de cette personne physique.

Le profilage est utilisé de manière courante dans le secteur des assurances dans le cadre de l’appréciation des risques.

Traditionnellement, l’assureur menait son analyse à partir du formulaire de déclaration du risque rempli par l’assuré. Désormais, le couplage de l’algorithme avec les objets connectés et la big data, permet aux assureurs d’affiner l’évaluation des risques.

L’algorithme assurantiel annonce ainsi une évaluation plus fine des risques s’appuyant sur des données.

Le régime particulier des décisions automatisées

En pratique, l’établissement de profils et le recours à des algorithmes, appliqués à des jeux de données personnelles, peuvent mener à la prise de décisions entièrement automatisées.

Tel est le cas lorsqu’une compagnie d’assurance utilise un algorithme pour calculer les primes d’assurance qu’elle offre aux clients potentiels via son site web.

L’article 22 du RGPD consacre le droit de ne pas faire l’objet de décision entièrement automatisée.

Pour les professionnels de l’assurance, ce droit, octroyé aux personnes concernées par le traitement (client, prospect, assuré etc.), se traduit par un principe d’interdiction générale du recours à l’algorithme décisionnel lorsque la décision :

- est fondée uniquement sur le traitement automatisé, c’est-à-dire sans intervention humaine ;

- produit des effets juridiques ou affecte de manière significative la personne concernée.

Tel pourrait être le cas lorsque le scoring obtenu par l’algorithme conduirait à appliquer des tarifs plus élevés, voire même à refuser la couverture d’individus jugés « à risque ».

Cette interdiction ne peut être levée en faisant intervenir artificiellement une personne humaine sans qu’elle ne s’implique dans le processus de décision. En effet, le G29 considère que la personne intervenant dans le processus doit avoir l’autorité et la compétence pour changer cette décision (2).

Cette interdiction pourra cependant être levée dans les cas où la décision est :

- nécessaire à la conclusion ou à l’exécution d’un contrat, à charge pour le responsable du traitement d’être en mesure de prouver qu’aucun autre moyen efficace et moins intrusif aurait permis d’atteindre le même objectif ;

- autorisée expressément par la loi ;

- ou fondée sur un consentement explicite de la personne concernée, tel qu’une déclaration écrite et signée de la personne concernée ou qu’un consentement en deux étapes.

Dans les cas où le profilage est autorisé, le professionnel de l’assurance devra encore :

- informer la personne concernée de l’existence d’une prise de décision automatisée, de la logique sous-jacente de l’algorithme, ainsi que de l’importance et des conséquences probables d’un tel profilage ;

- permettre à la personne concernée d’obtenir une intervention humaine, d’exprimer son point de vue et de contester la décision.

L’exigence de fournir la logique sous-jacente de l’algorithme vise notamment à éviter les boîtes noires, ces algorithmes opaques qui ne donnent aucune indication sur le « raisonnement » qu’ils ont suivi pour y arriver à leur décision.

A ce titre, l’explicabilité des algorithmes constitue ainsi un enjeu fondamental de conformité pour les professionnels de l’assurance. Cet enjeu a d’ailleurs été mis en lumière au sujet de l’intelligence artificielle dans le rapport de Cedric Villani (3).

Les professionnels de l’assurance devront s’assurer de l’explicabilité de leurs algorithmes décisionnels dès la conception de leur projet.

Smart contracts et blockchain en assurance

Les smart contracts sont des programmes informatiques chargés d’exécuter les termes d’un contrat, de manière automatique, sans intervention humaine, lorsque les conditions du contrat sont réunies.

Les smart contracts ont l’intérêt de réduire les coûts de vérification, d’exécution, d’arbitrage et de fraude.

En assurance, l’utilisation de smart contracts est particulièrement pertinente dans le cas de risques dits “paramétriques” c’est-à-dire dans le cas où l’assurance est liée à un indice objectif/ événement spécifique et tangible.

A titre d’exemple, l’assureur Axa a lancé une offre d’assurance paramétrique, baptisée Fizzy, qui déclenche automatiquement et immédiatement l’indemnisation des passagers en cas de retard de leur vol. L’assuré n’a pas de justificatif à fournir, il sait à l’avance la somme qui lui sera remboursée (en fonction du dommage qu’il a souhaité garantir à la souscription), le prix de la police est calculé en fonction du risque de retard (d’après les statistiques), tandis que l’assureur n’a pas de déclaration de sinistre à traiter.

C’est dans une telle situation que le couplage des objets connectés avec les smart contracts prend tout son sens. Les données enregistrées et transmises par les capteurs d’objets connectés (voiture, maison, etc.) vont permettre de générer automatiquement des dédommagements à l’assuré.

Par ailleurs, Fizzy et les smart contracts, de manière générale, sont souvent couplés avec la technologie blockchain, afin de rendre infalsifiables leurs termes et les conditions de leur exécution.

La blockchain est une base de données dans laquelle les données, registre immuable d’information, sont partagées de pair à pair entre les membres du réseau et dans laquelle toutes les écritures effectuées dans ce registre, appelées « transactions« , sont visibles de l’ensemble des utilisateurs, depuis sa création. Elle permet de stocker et d’échanger des données de manière sécurisée et décentralisée.

La Cnil a publié, le 24 septembre 2018, ses premiers éléments d’analyse sur la blockchain et sur sa compatibilité au RGPD (4).

Elle considère que le RGPD s’applique lorsque la blockchain concerne des données personnelles. Il convient alors de procéder à la qualification des acteurs au sens du RDPD (responsable du traitement, sous-traitant etc.).

La Cnil distingue trois types d’acteurs dans une blockchain :

- les « accédants » qui ont un droit de lecture et d’obtention d’une copie de la chaîne ;

- les « participants » qui ont un droit d’écriture (la création d’une transaction qu’ils soumettent à validation) ;

- les « mineurs » qui valident une transaction et créent les blocs en appliquant les règles de la blockchain, afin qu’ils soient « acceptés » par la communauté.

La multiplicité des acteurs intervenant dans le traitement de la donnée dans le cadre de la blockchain ne simplifie pas la qualification de ces derniers. La Cnil est néanmoins parvenue à dégager certaines tendances, applicables notamment au secteur de l’assurance.

La Cnil considère que le participant est susceptible d’être qualifié de responsable de traitement, notamment lorsqu’il est une personne morale qui inscrit une donnée à caractère personnel.

Si une compagnie d’assurance inscrit les données de ses clients dans une blockchain, dans le cadre de ses traitements de gestion des clients, elle pourra être qualifiée de responsable de traitement.

Il est également possible de considérer, dans certains cas, les « mineurs » comme des sous-traitants au sens du RGPD, notamment en ce qu’ils valident l’enregistrement de données à caractère personnel dans une blockchain pour le compte du responsable du traitement.

Par exemple, si plusieurs compagnies d’assurance décident de créer une blockchain à permission (5) pour leur traitement, ayant pour finalité le respect de leurs obligations légales de connaissance client, elles peuvent décider que l’une d’entre elle est responsable de traitement. Dans ce cas, les autres compagnies d’assurance qui valident les transactions, seront susceptibles d’être considérées comme étant « mineurs » et donc sous-traitants.

Concrètement, ces qualifications vont impliquer la signature obligatoire d’un contrat entre le participant et le « mineur », précisant les obligations de chaque partie et reprenant les dispositions de l’article 28 du RGPD.

Les différents acteurs risquent de rencontrer des difficultés pratiques à mener cette contractualisation dans le cadre d’une blockchain publique (6). La Cnil a annoncé mener actuellement une réflexion sur le sujet.

L’analyse d’impact : un outil de conformité pour les professionnels du secteur

L’article 35 du RGPD a instauré un outil important pour la responsabilisation des entreprises.

Ce dernier prévoit la conduite d’une analyse d’impact relative à la protection des données (AIPD – Data Protection Impact Assessment), lorsqu‘un traitement de données personnelles est « susceptible d’engendrer un risque élevé pour les droits et libertés des personnes concernées« .

Le G29 propose différents critères permettant de déterminer si une opération de traitement considérée nécessite une AIPD :

- évaluation/scoring (y compris les activités de profilage et de prédiction) ;

- décision automatique avec effet légal ou similaire ;

- surveillance systématique ;

- collecte de données sensibles ;

- collecte de données personnelles à large échelle ;

- croisement de données ;

- personnes vulnérables (patients, personnes âgées, enfants, etc.) ;

- usage innovant (utilisation d’une nouvelle technologie) ;

- exclusion du bénéfice d’un droit/contrat.

Le groupe de l’article 29 considère que, dans la plupart des cas, le responsable du traitement peut considérer qu’un traitement satisfaisant à deux critères nécessite une AIPD. Un regard rapide sur ces différents critères permet, à l’évidence, de comprendre que l’analyse d’impact constitue un outil incontournable dans le cadre de l’assurance algorithmique.

L’analyse d’impact aide, non seulement à construire un projet respectueux de la vie privée, mais constituera également un moyen pour les professionnels de l’assurance de démontrer leur conformité au RGPD.

Il convient pour les professionnels du secteur d’intégrer le recours à cet outil dans leur procédure interne.

Quelle éthique pour l’assurance algorithmique ?

La révolution du secteur de l’assurance est si puissante que de nombreux acteurs professionnels de l’assurance s’inquiètent d’une remise en cause d’un principe fondateur en assurance, celui de la mutualisation des risques. L’hyper-individualisation des offres induite par l’IA compromet l’idée même de l’assurance basée sur le partage du risque.

La Cnil s’est d’ailleurs récemment positionnée sur ce sujet, à l’occasion d’un grand débat public sur les algorithmes et l’IA (7). Elle se prononce en faveur de l’affirmation d’un principe de loyauté des algorithmes qui reposerait notamment sur l’idée que les critères d’un algorithme ne doivent pas entrer en opposition « trop frontalement » avec certains grands intérêts collectifs.

La mutualisation pourrait en ce sens faire partie intégrante d’un patrimoine collectif que l’algorithme – de personnalisation, de segmentation tarifaire, en l’occurrence – doit savoir prendre en compte.

L’assurance algorithmique compte encore ainsi de nombreux défis à relever. Un paramètre semble pour autant établi : son essor devra s’effectuer dans le respect de la protection des données à caractère personnel.

Didier Gazagne

Gabriel de Bousquet

Lexing Cyberdéfense – cybersécurité

(1) Règlement (UE) 2016/679 du 27-4-2016 relatif à la protection des personnes physiques à l’égard du traitement des données à caractère personnel et à la libre circulation de ces données.

(2) Lignes directrices sur le profilage, actualisation du 6-2-2018.

(3) « Donner un sens à l’intelligence artificielle : pour une stratégie nationale et européenne » Rapport de Cédric Villani au Premier ministre, 3-2018.

(4) Premiers éléments d’analyse de la Cnil sur la blockchain, 9-2018.

(5) Blockchains disposant de règles définissant les personnes qui peuvent participer au processus d’approbation ou même effectuer des transactions. Elles peuvent, selon les cas, être accessibles à tous ou être en accès limité.

(6) Blockchains accessibles à n’importe qui dans le monde. Toute personne peut effectuer une transaction, participer au processus de validation des blocs ou obtenir une copie de la blockchain.

(7) Synthèse de la Cnil, « Comment permettre à l’homme de garder la main ? les enjeux éthiques des algorithmes et de l’IA » 9-2017.